MCP verständlich erklärt: Der USB‑C‑Anschluss für KI‑Agenten

Im Zeitalter der KI‑getriebenen Neugestaltung der Medien‑Wertschöpfungskette steigt die Effizienz von der Einzeloptimierung zur algorithmisch gesteuerten, ganzheitlichen Zusammenarbeit. Gleichzeitig bremsen Dateninseln und „Silo‑Integrationen“ über unzählige proprietäre Schnittstellen die KI‑Integration bestehender Techniklandschaften.

Diese Hürden erschweren es Unternehmen, Daten und Systeme sicher und skalierbar mit LLMs zu verbinden. MCP setzt genau hier an.

Dieser Beitrag beleuchtet MCP von der Architektur bis zu Einsatzszenarien und zeigt, wie das Prinzip „einmal verbinden, überall nutzen“ Datenpotenziale hebt – Technologien werden nicht zum Bremsklotz, sondern zum Wachstumsmotor.

[Hauptautor @bexzhang, Überarbeitung @osli, Quelle: Tencent Cloud Smart Media]

I. Ursprung von MCP

Hintergrund und Schmerzpunkte

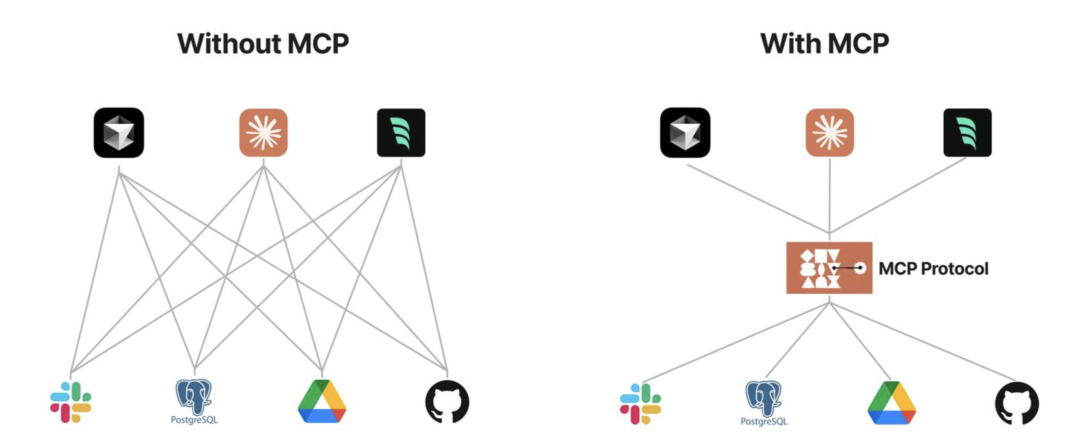

In realen Projekten dominieren „Schornstein‑Integrationen“: Jedes Modell koppelt separat an jede Datenquelle oder jedes Tool. Das führt zu hohen Kosten, Sicherheitsrisiken und schlechter Skalierbarkeit. Hinzu kommen sensible Unternehmensdaten, lange Freigabeprozesse und das Fehlen eines offenen, gemeinsamen Standards.

Zwar existieren Frameworks (z. B. LangChain, LlamaIndex, Vercel AI SDK), doch oft erfordern sie umfangreiche projektspezifische Implementierungen – schwer zu standardisieren und zu warten.

Bei manchen Projekten ist die Abstraktion zu hoch und die Architektur inkonsistent – mit wachsender Komplexität kippt die Entwicklererfahrung. Außerdem steht Kommerzialisierung nicht selten vor Ökosystem‑Pflege.

Das Vercel AI SDK abstrahiert eleganter – insbesondere in der UI‑Integration –, ist aber stark an Next.js gebunden und unterstützt andere Stacks nur begrenzt.

Entstehung und Ziele

Initiator: Anthropic (Entwickler von Claude), Veröffentlichung Ende 2024, open source. https://www.anthropic.com/news/model-context-protocol

Kernziele: Ein standardisiertes Protokoll wie USB‑C – eine einheitliche Schnittstelle zwischen KI‑Modellen und externen Ressourcen. „Einmal integrieren, überall nutzen“. Sicherer Zugriff auf lokale und entfernte Daten und Tools.

Technische Zeitleiste:

| Zeit | Phase | Schlüsselereignis |

|---|---|---|

| vor 2023 | Frühphase | Eigene Function‑Call‑Schnittstellen pro KI |

| 2023 | Keimphase | Frameworks versuchen allgemeine Tool‑Aufrufe |

| Nov 2024 | Geburt | Anthropic veröffentlicht MCP 1.0 (Open Source) |

| Q1 2025 | Ökosystem‑Boom | >200 Drittanbieter‑MCP‑Server auf GitHub |

II. Konzept und Vorteile von MCP

Definition

MCP ist ein offenes Protokoll, das die Interaktion zwischen KI‑Modellen und externen Datenquellen/Tools standardisiert. Kerngedanken:

- Einheitliche „Übersetzungsebene“: Heterogene APIs werden zu standardisierten, modellverständlichen Aufrufen.

- Sichere Verbindungsschicht: Zugriff auf lokale und entfernte Ressourcen, ohne Datenzwang in die Cloud.

Rückblickend hätte ein solcher Standard gut zu einem frühen Zeitpunkt der GPT‑Veröffentlichungen gepasst. Doch anstelle eines offenen Ökosystems entstanden teils proprietäre Pfade. Solche Standardisierungen entstehen selten rein aus der Community – meist braucht es treibende Akteure.

Anschauliche Vergleiche

Metapher „Universalfernbedienung“

Jedes Unternehmenssystem ist wie ein eigenes „Gerät“ mit eigener Fernbedienung (API). MCP ist die Universalfernbedienung: Der KI‑Assistent steuert Video‑Feeds, regelt „Temperaturen“ (Last), erzeugt Berichte – alles über standardisierte „Tasten“ statt Spezial‑Fernbedienungen.

Metapher „USB‑C der KI“

Wie USB‑C Geräte mit verschiedensten Peripherien verbindet, verbindet MCP KI‑Assistenten mit Datenbanken, E‑Mail‑Systemen, Reports u. v. m. – ein Stecker, viele Zwecke. Für Nutzer heißt das: mehr Möglichkeiten, weniger Integrationsaufwand.

Vorteile von MCP

MCP (Model Context Protocol) ist ein Kontext‑Protokoll für LLM‑Anwendungen. Gegen typische Probleme wie Dateninseln und komplexe Tool‑Integrationen bietet MCP:

- Ökosystem – viele fertige Server/Plugins, die direkt genutzt werden können

- Einheitlichkeit – nicht auf ein einzelnes Modell beschränkt; jedes MCP‑fähige Modell kann flexibel verwendet werden

- Datensicherheit – Sie steuern, welche Daten über die Schnittstellen übertragen werden

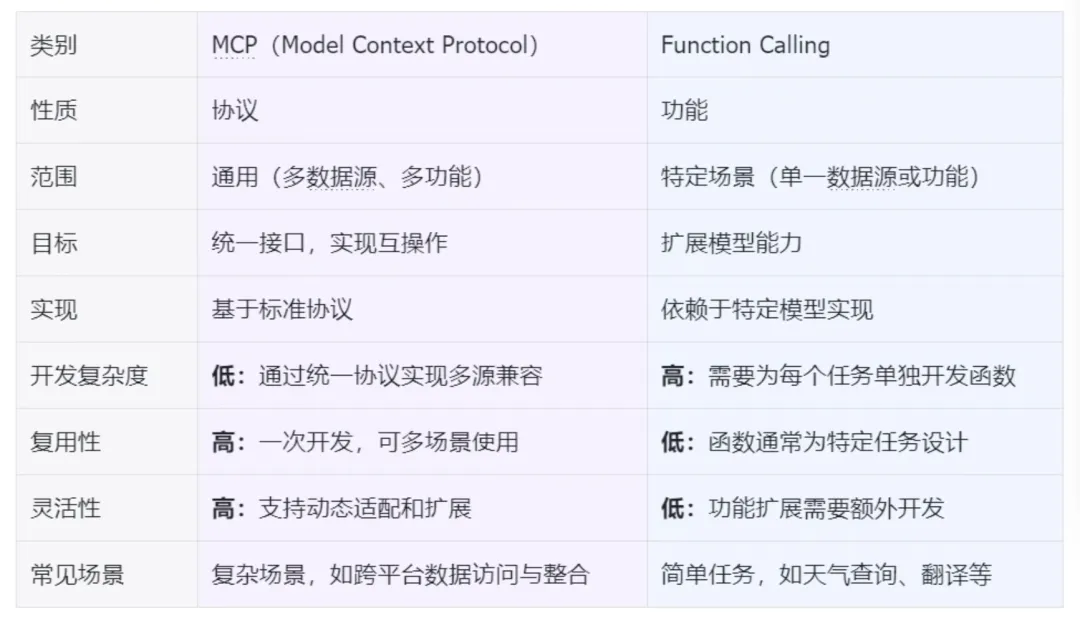

MCP vs. Function Calling

| MCP (Model Context Protocol) | Function Calling |

|---|---|

| Beide Ansätze erhöhen die Interaktion zwischen KI und externen Daten; MCP adressiert zusätzlich Integrationen in Anwendungen. | |

| MCP‑„Primitives“ (Prompts/Resources/Tools) ermöglichen komplexe Interaktionen; Function Calling ist meist unidirektional. | |

| Beide erfordern Modell/Client‑Support (Protokoll‑ bzw. Funktions‑Features). |

III. Funktionsprinzipien und Architektur

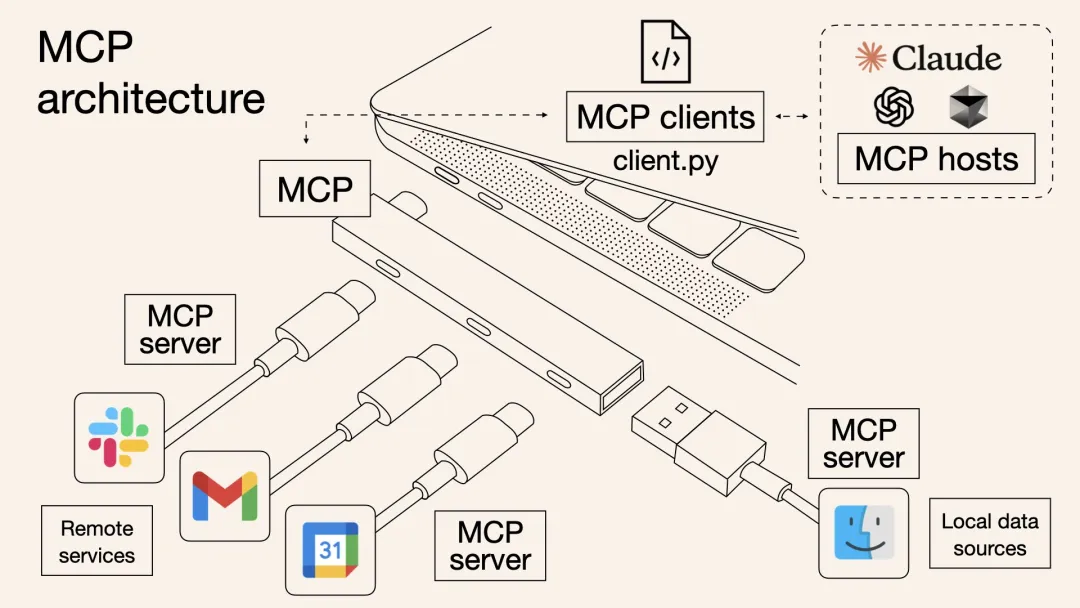

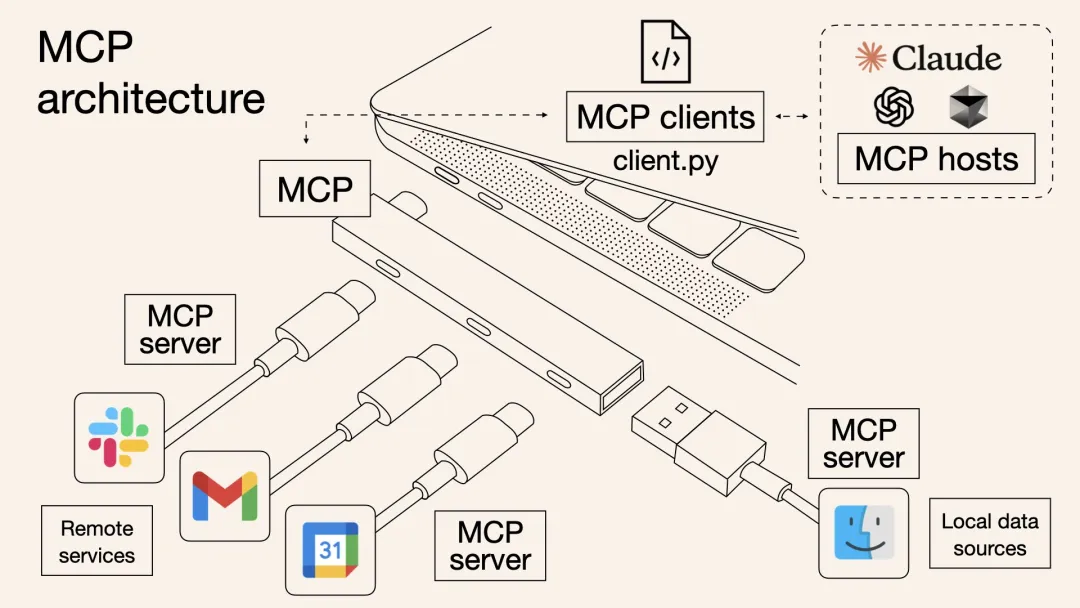

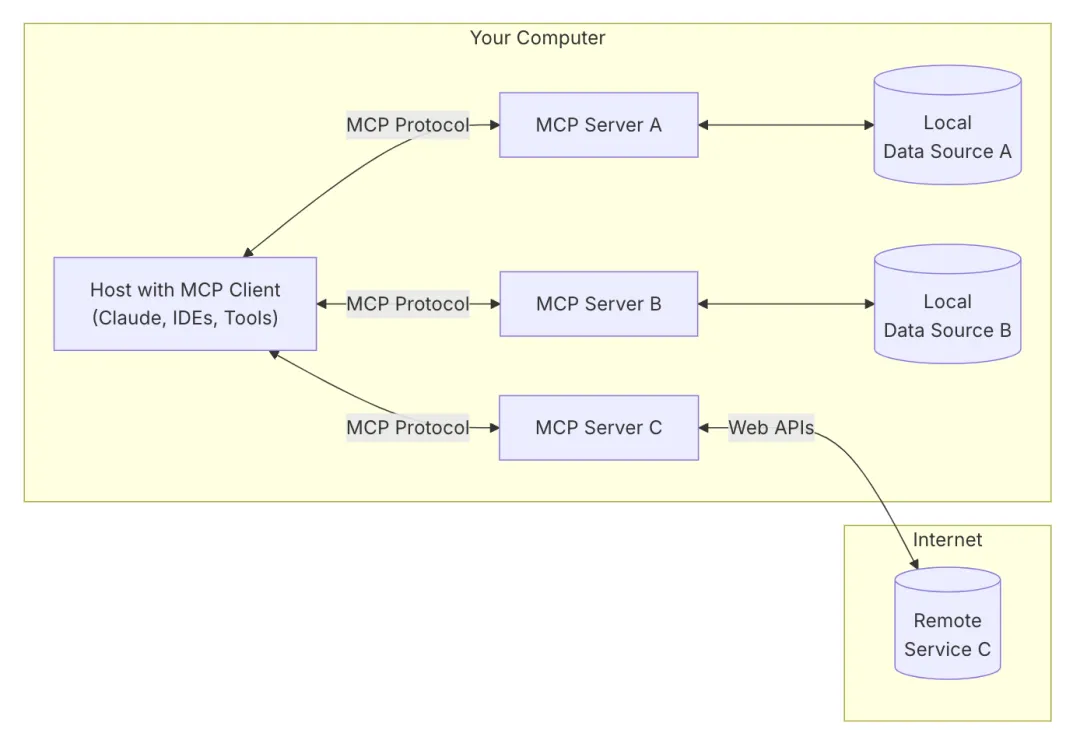

Kernarchitektur

MCP nutzt eine Client‑Server‑Architektur. Die Kommunikation zwischen LLM und Ressourcen ist sauber geschichtet: Client, Server, Ressourcen. Das erlaubt präzise Zugriffskontrollen – nur autorisierte Zugriffe gelangen zu konkreten Ressourcen.

- MCP Host (Host‑App): LLM‑Anwendungen wie Cursor, Claude Desktop, Cline.

- MCP Client: Hält je Server eine 1:1‑Verbindung innerhalb der Host‑App; mehrere Clients können parallel laufen.

- MCP Server: Leichtgewichtige, separate Prozesse, die Kontext, Tools und Prompts standardisiert bereitstellen.

- Lokale Datenquellen: Dateien, Datenbanken, APIs lokal.

- Entfernte Dienste: Externe Dateien, Datenbanken, APIs.

Vorteile: Modularität (Server pro Quelle/Anwendung), Entkopplung (Protokoll statt Quell‑Spezifika), bidirektionale Interaktion (Server können Modell‑Sampling anstoßen) – ideal für komplexe Workflows.

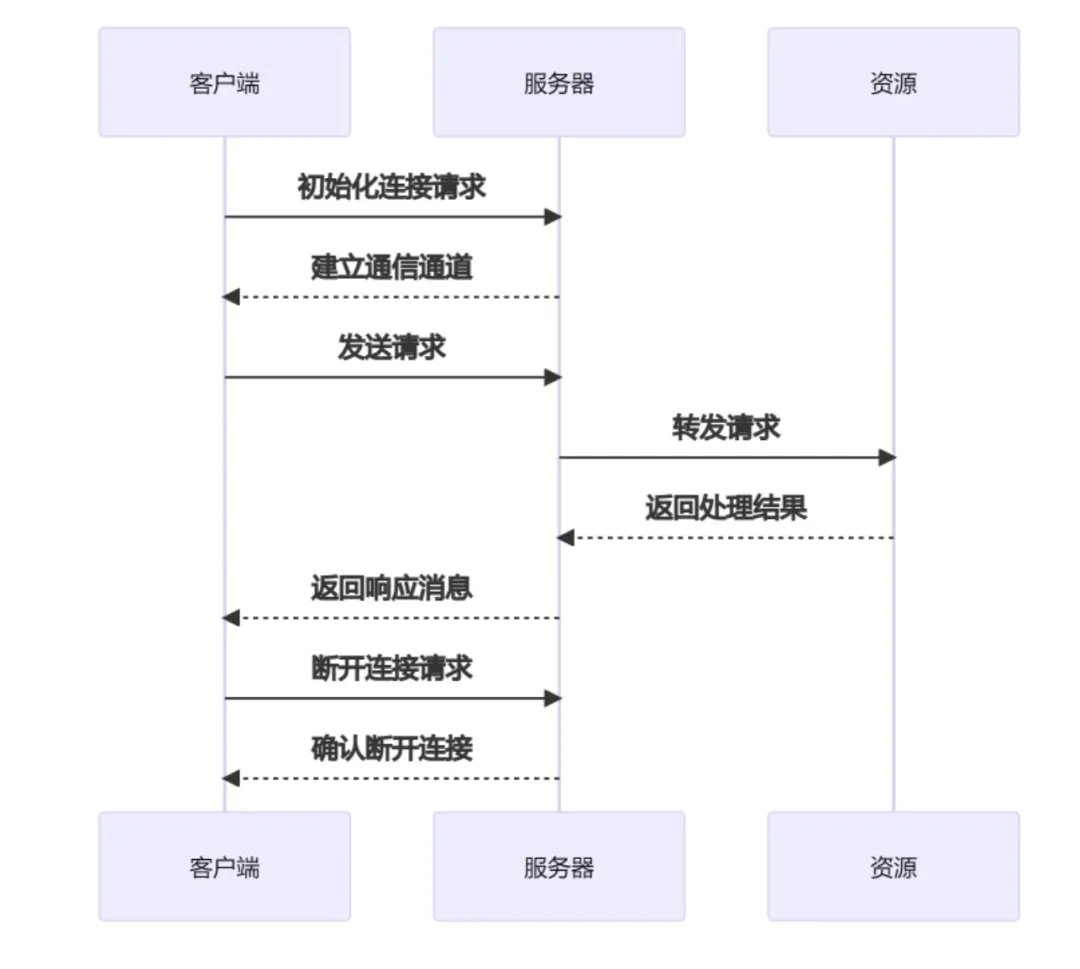

Ablauf

- Initialisierung: Client baut Verbindung zum Server auf

- Anfrage: Client sendet je Bedarf eine Anfrage

- Verarbeitung: Server parst und führt Operationen aus (Datenbank, Dateien …)

- Antwort: Server sendet Ergebnis zurück

- Beenden: Client schließt Verbindung oder wartet auf Timeout

Kommunikation

MCP nutzt JSON‑RPC 2.0 als Nachrichtenprotokoll. Kerneigenschaften:

- Flexible Transporte: STDIO (lokal) und SSE+HTTP POST (remote), weitere Transporte möglich.

- Transparente Nachrichten: JSON‑basierte Requests/Results/Notifications, methoden‑ und parameterbasiert.

- Entwicklerfreundlich: Lesbare JSON‑Logs, Fehlerweitergabe, Concurrency‑Handling – Fokus auf Business‑Logik.

Zentrales Konzept – „Primitives“: Interaktionen sind in Primitives gegliedert, die klar Rollen und Fähigkeiten von Client/Server definieren.

MCP‑Server bieten drei Primitives:

- Prompts: Vorlagen/Prompt‑Texte zur Lenkung des Modells (z. B. „Code‑Review‑Prompt“).

- Resources: Strukturierte Inhalte, die als Kontext gelesen werden (Datenbankzeile, Notiz, …) – quasi schreibgeschützt.

- Tools: Ausführbare Funktionen mit potenziellen Nebenwirkungen (E‑Mail senden, Wetter abrufen …) – stets mit Nutzerfreigabe.

MCP‑Clients stellen zwei weitere Primitives bereit:

- Roots: Vom Client bereitgestellte Einstiegspunkte ins Dateisystem – strikt autorisiert.

- Sampling: Server können Modell‑Vervollständigungen beim Client anfordern (für rekursive/mehrstufige Agentenlogik) – mit Augenmaß einsetzen.

Die klare Trennung der Primitives macht Absichten transparent (Kontext vs. Aktion), verbessert Genehmigungs‑/Auditierbarkeit und verhindert „versteckte“ Side‑Effects.

IV. MCP‑Server: Klassen und Anwendungen

Als Kern von MCP lassen sich Server grob in drei Gruppen einteilen: Offizielle, Drittanbieter‑ und Community‑Server.

1. Offizielle MCP‑Server

(Vom MCP‑Kernteam gepflegt; Referenzimplementierungen mit Best Practices)

Kern‑Infrastruktur

- modelcontextprotocol/server-filesystem (Dateisystem): Standardisierte Datei‑Schnittstellen, feingranulare Berechtigungen. https://github.com/modelcontextprotocol/servers/tree/main/src/filesystem

Erweiterungs‑Tools

- modelcontextprotocol/Google Drive (Cloud‑Dateien): Integration mit Google Drive; Auflisten, Lesen und Suchen. https://github.com/modelcontextprotocol/servers/tree/main/src/gdrive

KI‑Erweiterungen

- modelcontextprotocol/aws-kb-retrieval-server (Vektordatenbank): Offizielle Vektor‑Retrieval‑Lösung; Speicherung hochdimensionaler Daten & Ähnlichkeitssuche. https://github.com/modelcontextprotocol/servers/tree/main/src/aws-kb-retrieval-server

2. MCP‑Server von Drittanbietern

(Von Anbietern/Teams gepflegt, mit tiefer Branchenintegration)

Datenbankdienste

- Tinybird MCP Server (Echtzeit‑Datenanalyse): Für Zeitreihen optimiert; SQL‑Abfragen mit niedriger Latenz. https://github.com/tinybirdco/mcp-tinybir

Clouddienste

- Qdrant MCP Server (Vektor‑Suche/Cloud): Enterprise‑Vektor‑Suche, unterstützt Hybrid‑Search & verteilte Deployments. https://github.com/qdrant/mcp-server-qdrant/

KI‑Dienste

- LlamaCloud Server (LLM‑Hosting): Multimodale Schnittstellen, Feintuning und Inferenz‑Monitoring. https://github.com/run-llama/mcp-server-llamacloud

Entwicklertools

- Neo4j (Graphdatenbank): Graphdatenbank mit Cypher, Knowledge‑Graph‑Aufbau. https://github.com/neo4j-contrib/mcp-neo4j/

Erweiterungs‑Tools

- Firecrawl (Web‑Crawling): Crawlen, Suchen, Extrahieren, tiefe Analysen & Batch‑Crawling. https://github.com/mendableai/firecrawl-mcp-server?tab=readme-ov-file#firecrawl-mcp-server

3. Community‑MCP‑Server

(Von der Community beigetragen – Long‑Tail‑ und experimentelle Szenarien)

Lokale Tool‑Integration

- punkpeye/mcp-obsidian (Wissensmanagement): Bidirektionale Synchronisation von Obsidian‑Notizen, optimierte Markdown‑Analyse. https://github.com/punkpeye/mcp-obsidian

Automatisierungstools

- appcypher/mcp-playwright (Browser‑Automatisierung): Web‑Automatisierung via Playwright, unterstützt dynamische JS‑Ausführung. https://github.com/appcypher/awesome-mcp-servers#browser-automation

Branchenspezifische Tools

- r-huijts/mcp-aoai-web (Zugriff auf Kunst‑Daten): Zugriff auf Bestände des Rijksmuseums via natürlicher Sprache; Metadatensuche. https://github.com/r-huijts/rijksmuseum-mcp

Entwicklertools

- sammcj/mcp-package-version (Abhängigkeits‑Management): Realtime‑Abfragen von npm/PyPI‑Versionen; verhindert Halluzinations‑Vorschläge. https://github.com/sammcj/mcp-package-version

Privacy‑Enhancing Tools

- hannesrudolph/mcp-ragdocs (Lokale Dokumentenrecherche): Datenschutzfreundliche Recherche über lokalen Vektor‑Index. https://github.com/hannesrudolph/mcp-ragdocs

4. Vergleich nach Kategorien

| Dimension | Offizielle Server | Drittanbieter‑Server | Community‑Server |

|---|---|---|---|

| Pflegezyklus | Langfristig, regelmäßige Releases | Abhängig vom Anbieter | Abhängig von Aktivität der Maintainer |

| Protokoll‑Kompatibilität | 100 % gemäß MCP‑Spezifikation | Meist Kern‑Spezifikation | Teils experimentelle Erweiterungen |

| Security‑Audit | Offizielle Audits | Teilweise Enterprise‑Audits | Keine Pflicht‑Audits |

| Deploy‑Komplexität | Standardpakete & Dokus | Anbieter‑Credentials nötig | Häufig manuelles Dependency‑Tuning |

| Typische Szenarien | Basisfunktionen/Kerngeschäft | Tiefere Branchenszenarien | Individuelles/Experimentelles |

Hinweis: Unterstützung für Remote‑MCP‑Verbindungen

Die Transport‑Beschreibung kann den Eindruck erwecken, Remote‑MCP sei bereits verfügbar. Tatsächlich laufen Client und Server derzeit lokal. Für Remote‑Szenarien ist aktuell ein zusätzlicher, lokaler Bridge‑Server erforderlich.

Das ist für 2025 als Top‑Priorität eingeplant: https://modelcontextprotocol.io/development/roadmap

Ziele:

- Authentication & Authorization: Standardisierte AuthN/AuthZ (fokus auf OAuth 2.0)

- Service Discovery: Definierte Client‑Discovery für Remote‑Server

- Stateless Operations: Serverless‑taugliche, möglichst zustandsarme Operationen

Referenzen:

[1]https://www.anthropic.com/news/model-context-protocol

[2]https://modelcontextprotocol.io/development/roadmap

[3]https://github.com/modelcontextprotocol

[4]https://mcp.so/servers

[5]https://github.com/punkpeye/awesome-mcp-servers

[6]https://github.com/appcypher/awesome-mcp-servers

[7]https://github.com/modelcontextprotocol/python-sdk

[8]https://github.com/punkpeye/awesome-mcp-servers?tab=readme-ov-file#frameworks

[9]https://mp.weixin.qq.com/s/Toj2TudFNXx6_Z11zSRb2g